AIガバナンスとは、AIシステムの企画から運用・廃止までを経営層の責任のもとで統制し、リスクを抑えながら価値創出を最大化する枠組みです。

この体制を整えることで、法規制への確実な対応や顧客・投資家からの信頼を得ながら、安全かつ公平にAIを活用できます。

一方で、ガバナンスが不十分なままAIを導入すると、差別的判断やデータ漏えいなどのリスクが表面化し、ブランドや業績に大きな影響が及ぶおそれがあります。

そこで本記事では、AIガバナンスの基礎、求められる背景、リスクの種類、国際・国内ガイドラインの要点、実践ステップや支援ツールまでをまとめて解説します。

AIを安心してビジネス成長に生かしたい方は、ぜひご一読ください。

目次

AIガバナンスとは

AIガバナンスとは、AIを安心・安全に活用しながら、その価値を最大限に引き出すための仕組みです。

具体的には、AIの企画から運用・廃止に至るまでの全プロセスを経営レベルで管理し、倫理・法律・安全性の観点からリスクを抑えます。

いわば「AIにおける企業統治+リスク管理+法令順守」を一体化させた総合ルールのことを指します。

OECDが示す「信頼できるAI」の原則や、日本政府が2025年3月に改訂した「AI事業者ガイドライン(第1.1版)」などが示すとおり、ガバナンスの核心は「透明性・説明責任・公平性・安全性」の四本柱を組織横断で担保することにあります。

単なる技術管理ではなく、取締役会や経営会議が方針を定め、現場がプロセスやツールで実装し、監査部門が独立して検証する三層構造を整えることで、法規制の強化や社会的信頼の要求に応えながら事業成長を加速させる。

これが現代企業に求められるAIガバナンスの出発点です。

参考:AI事業者ガイドライン(METI/経済産業省)

AI principles|OECD

ガバナンスとは?ビジネスにおける意義と実践方法|LISKUL

定義と範囲

AIガバナンスの定義は「組織がAIに関する方針・基準・プロセスを策定し、継続的に監督・改善する統治メカニズム」です。

対象範囲はアルゴリズムそのものに加え、データ取得・学習・評価・運用・廃棄の各段階、そして人材・組織体制・外部委託先まで含みます。これにより、モデル性能の低下やバイアス、プライバシー侵害といったリスクを発生源で制御できる体制を築けます。

ガバナンスはAI倫理やコンプライアンスを包含しつつ、経営目標の達成とリスク最小化を両立させる戦略的マネジメント領域として位置付けられます。

AI倫理・コンプライアンスとの違い

AIガバナンスとAI倫理・コンプライアンスの違いは、「経営レベルで全社的に統制・運用される仕組みかどうか」です。

AI倫理やコンプライアンスは、AI活用における価値観や法令順守の基準を示すものであり重要です。しかし、誤作動や差別、責任の所在など、AI導入後に発生する実務的な課題への対応までを十分にカバーしているわけではありません。

それぞれの位置づけは以下のとおりです。

- AI倫理:公平性・説明可能性・人権の尊重など、望ましい価値観に基づく指針

- コンプライアンス:法律やガイドラインに適合させるための最低限の義務

- AIガバナンス:倫理・法令の視点に加え、リスク評価、モニタリング、監査、改善を一貫して管理するための組織的な統治体制

AIガバナンスを確立することで、AI導入によるスピードや効率性を確保しつつ、社会的信頼を損なわない形で事業インパクトを持続的に拡大できます。

AIガバナンスが必要とされる背景にある5つの要因

生成AIの急速な普及により、企業はかつてないスピードで新サービスを市場に投入できる一方で、法規制や社会的責任への対応を誤ればブランド価値を損ないかねません。

AIガバナンスは、機会とリスクが表裏一体となった環境で、成長エンジンを安全に回し続けるために欠かせない経営インフラです。

1.規制強化と国際競争の加速

欧州のAI Actをはじめ各国で網羅的な法律が相次いで成立し、違反時の制裁金は売上高の一定割合という高額設定が一般化しつつあります。

規制をクリアした企業だけがグローバル市場で取引先として選ばれる構図が鮮明になり、ガバナンス体制の有無が競争力と直結しています。

2.レピュテーションリスクの顕在化

AIの誤作動やバイアスによる差別問題が報道されるたびに、企業はソーシャルメディアで厳しい批判を浴び、株価が変動する例も見られます。

透明性や説明責任を示せない企業は、顧客や投資家からの信頼を失い、長期的なブランド毀損に直面します。

3.技術の複雑化と責任分界の不透明さ

深層学習モデルは高度にブラックボックス化しており、開発部門だけでは性能低下やデータ漏えいの兆候を把握しきれません。

取締役会から現場までを一貫させたガバナンス構造を整備することで、モデルの品質や安全性を継続的に監視できる仕組みが求められます。

4.サプライチェーンへの影響と取引要件の高度化

大手企業や官公庁は、取引先に対してAIガバナンス方針の提示を義務づけるケースが増えています。

自社だけでなくパートナー企業も含めたサプライチェーン全体でガバナンスを担保しなければ、大口案件から排除されるリスクが高まります。

5.市場機会の最大化

適切なガバナンスを敷くことで、AI導入スピードを落とすことなく、プロダクトの信頼性を競合より早く証明できます。

結果として、規制対応コストを投資に転じ、ビジネス拡大のチャンスを逃さないポジティブスパイラルを生み出せます。

AIリスクの主な種類3つ

AIリスクは「技術」「倫理・社会」「法規制」の3つで整理すると、抜け漏れなく優先順位を付けやすくなります。

いずれも放置すれば事故発生時に巨額の損失やブランド毀損を招くため、経営レベルで一元管理することが不可欠です。

1.技術的リスク

アルゴリズムの性能低下や予期せぬ振る舞いは、誤判定・誤出力を引き起こし、業務プロセスや顧客体験に直接的な影響を与えます。

モデルは学習データの偏りや経年劣化(モデル・ドリフト)によって精度が下がり、さらにadversarial attackやデータ漏えいといったセキュリティインシデントも発生し得ます。

技術的リスクを抑えるには、データ品質管理、継続的なモデル監視、定期的な再学習が必要です。

2.倫理・社会的リスク

AIが意思決定を自動化する過程で、差別や排除につながるバイアスが生まれる恐れがあります。

説明可能性が不足すれば、利用者やステークホルダーが判断根拠を理解できず、不信感が拡大します。さらに、AIが生む結果が社会規範や文化と衝突すると、企業は批判を受け、レピュテーションが損なわれます。

多様性を担保したデータ選定と説明責任の明確化が対策の要です。

参考:デジタル倫理の事例6選。倫理的ビジネス環境を構築するための基礎|LISKUL

3.法的・規制リスク

個人情報保護法や著作権法、さらには域外適用されるEU AI Act等に違反すると、高額な制裁金や取引停止処分を科される可能性があります。

また、AIによる誤判断で損害が生じた場合の責任帰属が曖昧だと、訴訟リスクが顕在化します。

契約管理、監査証跡の保持、法務部門との連携を通じて、規制要件を満たすプロセスを組み込むことが求められます。

AIガバナンスの原則5つ

AIガバナンスを機能させるには、経営層から現場までが共有できる「共通ルール」を明確に定め、日々の意思決定に組み込むことが不可欠です。

国際的にはOECD AI原則やG7広島AIプロセスが指針となり、日本でも2025年改訂のAI事業者ガイドラインが同趣旨を示しています。

本章では、それらを実務に落とし込む際の核となる5つの原則を紹介します。これらを社内ポリシー・チェックリスト・監査基準に反映すれば、AIの価値を最大化しながらリスクを体系的に抑制できます。

1.透明性と説明責任

モデルの構造や判断根拠が外部から見えないままでは、ステークホルダーの信頼は得られません。

情報開示レベルを「ユーザー向け概要」「規制当局向け詳細」「社内技術ドキュメント」の三層に分け、目的に応じた説明可能性を確保することが重要です。

役員は開示方針を承認し、現場は監査証跡を残す、そしてリスク管理部門が適切性を定期レビューする。この連携によって説明責任が果たされます。

2.公平性・非差別

学習データの偏りがそのままサービス差別につながれば、社会的批判だけでなく法的制裁も招きます。

データ収集段階で多様性を担保し、モデル評価時には年齢・性別・民族などの属性別に誤差を計測するテストを組み込みましょう。

ビジネス観点では、特定集団の購買機会を不当に奪わないことが市場規模拡大にも直結します。

3.プライバシーと安全性

個人情報保護とサイバーセキュリティは、AIガバナンスの中でも最も違反コストが高い領域です。

暗号化や匿名加工、権限管理など既存のセキュリティ対策に加え、モデルからの情報漏えいを防ぐ「推論時プライバシー保護」も導入します。

加えて、敵対的攻撃に備えたレッドチーム演習を定期的に実施し、攻撃手法のアップデートに追随できる体制を維持することが求められます。

4.人間中心と管理可能性

AIは意思決定を支援するツールであり、最終的な責任は必ず人が負うという原則を明示する必要があります。

具体的には「重大な判断を自動化しない」「閾値を越えるリスクスコアが出た場合は人間がレビューする」といったルールを設定し、ヒューマン・イン・ザ・ループを確立します。

これにより、AIの恩恵を享受しつつ、人間の倫理観や判断力を最終安全弁として機能させられます。

5.継続的改善と監査

AIシステムはリリース後も環境変化とともに性能が変動します。

ガバナンス体制には、KPIモニタリング → 異常検知 → 原因分析 → モデル更新というPDCAサイクルを組み込み、改善結果を経営層まで報告するフローを定義しましょう。

外部第三者や内部監査部門による定期監査を実施し、ガイドライン適合性と実運用のギャップを可視化すれば、法令改正や新たな社会要請にも迅速に適応できます。

AIガバナンスのPDCAプロセス

AIガバナンスは「一度作って終わり」ではなく、AIモデルや事業環境の変化に合わせて進化させ続ける必要があります。

その土台となるのが、方針策定から改善までを循環させるPDCAプロセスです。以下では各フェーズで押さえるべきポイントを解説します。

Plan:ガバナンス方針と指標の策定

経営層主導でミッションとリスク許容度を定め、AI活用のゴールを数値化します。

具体的には「差別的出力ゼロ」「誤予測率◯%以下」「説明可能性レベルの向上」といったKPIを設置し、コンプライアンス部門や現場エンジニアと合意形成します。

方針にはガイドラインや規制への適合要件も織り込み、契約書やRFPのテンプレートに反映してサプライチェーンへ展開するところまで計画段階で定義しておくと、運用時の摩擦を減らせます。

Do:リスク管理と運用体制の実装

計画で定めた基準をもとに、データ収集プロセスやモデル開発フローにレビューステップを組み込みます。

たとえば、データはメタデータ付きでリポジトリに登録し、学習前にバイアステストを実施。モデルはMLOpsパイプラインにセキュリティスキャンやライブラリ脆弱性チェックを追加し、デプロイ後は推論ログを集中管理しておくと、後工程の監査に活用できます。

責任分担は「経営層=方針承認」「ガバナンス委員会=評価・承認」「実務チーム=実装・記録」という三層で明確化し、外部委託先にも同じ役割分担表を提示します。

Check:モニタリングと監査

運用開始後はリアルタイム監視と定期監査の二段構えで性能とリスクを把握します。

リアルタイム監視では、精度劣化や異常入力を検知する自動アラートを設定します。定期監査では、外部・内部の第三者がデータセット、モデル、ログ、説明資料をクロスチェックし、方針への適合状況を評価します。

監査結果は取締役会へエスカレーションし、重大インシデントが発生した場合は是正計画の提出を義務付けることで、経営レベルでの把握と責任追及を可能にします。

Act:改善と知見の共有

監査で得た改善提案やモニタリング報告を受け、モデル再学習やワークフロー修正を実施します。

この際、変更点をドキュメント化し、影響範囲を関係部門へ展開することで横展開を促進。

さらに、改善後の成果をKPIで検証し、達成度を役員レポートや社内ポータルで共有すると、次のPlanフェーズでの目標設定に活用できます。

こうした知見の循環が、AIガバナンスを“守りの仕組み”から“競争力を高める武器”へと進化させる鍵になります。

AIガバナンスに関する国内外のガイドライン

AIガバナンスを実務に落とし込むうえでは、世界各地で公開されているガイドラインを「同じ地図上」に並べて比較し、その共通点と相違点を理解することが欠かせません。

どの文書も透明性・公平性・安全性といった価値観を共有していますが、法的拘束力や適用範囲は少しずつ異なります。

本章では、ガイドラインの「国際原則」「地域法」「国内指針」「業界標準」の4つを紹介します。

1.国際原則とソフトロー

最も広く参照されているのがOECD AI原則(2019年)です。「人間中心」「説明責任」「包摂的成長」など5つの原則を掲げており、加盟38か国が政策評価の指針としています。

その後、ユネスコの「AI倫理勧告」(2021年)やG7広島AIプロセス(2023年)も登場し、生成AIなど先端技術のリスクに焦点を当てています。

これらは法的拘束力こそ弱いものの、国境を越える取引やサプライチェーン管理の“最低ライン”として機能しています。

2.地域レベルの規制フレームワーク

各国・地域では、AI技術の急速な進展に対応するため、独自の規制枠組みが整備されつつあります。

以下では、主要な三極(EU、米国、中国)におけるAI規制の特徴と、それぞれが企業にもたらす影響について解説します。

地域法は罰則を伴うため、海外展開を視野に入れる日本企業は「最も厳しい基準(たとえばEU)」に合わせて設計しておくと、将来的な再対応コストを抑えやすくなります。

EU AI Act

2025年3月に最終採択されたAI規制法で、リスクに応じて「禁止」「ハイリスク」「限定」「最小」の4段階に分類し、それぞれに異なる義務を課します。

違反には最大で全世界売上高の7%という制裁金が科されるため、グローバル企業にとって極めて厳格な制度と位置づけられています。

参考:EU AI Act

米国NIST AI RMF1.0

国立標準技術研究所(NIST)が策定した自主的なフレームワークで、リスクベースでのAI活用を支援する内容となっています。

義務規定ではないものの、政府調達や大企業のパートナー要件として採用が進み、実質的な業界標準となりつつあります。

中国「生成AI暫定管理弁法」

2023年に施行された規制で、生成AIサービスに対し、コンテンツの安全審査やデータ出所の明示を義務付けています。

さらに、越境データの移転についても厳格に制限しており、安全保障と情報統制を重視した運用が特徴です。

3.日本国内ガイドライン

日本では経済産業省・総務省が共同で策定した「AI事業者ガイドライン(第1.1版)」(2025年3月改訂)が中核となります。

ライフサイクル全体のリスク管理を視野に入れつつ、開発者と利用者の責任分担を10の指針に整理しています。

さらに、金融庁の「金融分野におけるAI活用方針」や厚生労働省の「医療AI指針」など、業界別ガイダンスも続々と公表されています。ポイントは「説明可能性の確保」「第三者検証の実施」「監査記録の保存」の三点です。

参考:AI事業者ガイドライン(第1.1版)

金融庁:AIディスカッションペーパーの公表について:金融庁

医療デジタルデータの AI 研究開発等への利活用に係るガイドライン|厚生労働省

4.業界・技術標準

AIに関する運用・設計・監査の信頼性を高めるため、国際的な標準化団体や業界団体が技術ガイドラインを整備しています。

以下に、代表的な標準規格やベンチマークを紹介します。

ISO/IEC42001:2023(AIマネジメントシステム)

AIの品質・セキュリティ・倫理を統合的に管理するための国際規格で、組織レベルのマネジメント体制を定義しています。

ISO9001などの他の管理規格との整合性も高く、全社的なAI統治の基盤として活用が可能です。

ISO/IEC23894・IEEE7000シリーズ(テーマ別ガイドライン)

ISO/IEC23894はAIにおけるバイアスリスク対策、IEEE7000シリーズは倫理的設計や説明責任の確保など、特定テーマに特化した規格群です。

いずれも、社内ポリシーや開発プロセスのチェックリスト整備に役立ちます。

参考:ISO/IEC23894

IEEE 7000-2021

MLCommons MLPerf・OpenSSF AI Security(ベンチマーク/OSS基準)

MLCommonsが提供するMLPerf Auditingは、機械学習モデルの性能を比較可能にするベンチマークで、オープンソース実装も整備されています。

OpenSSF AI Securityは、OSSセキュリティの原則をAI開発に適用するもので、実装段階でのセキュリティ評価に適しています。

参考:MLPerf-Inference Audit Guidelines

OpenSSF AI Security

企業が取るべき実践ステップ

AIガバナンスを社内に根づかせるには、「経営層の明確な意思表示」「専門家を束ねるガバナンス委員会」「現場で機能するチェックリストと監査ツール」という三位一体の仕組みが欠かせません。

これらを同時に動かすことで、AI活用のスピードを落とさずにリスクを抑え、外部ステークホルダーからの信頼を確立できます。

1.経営層コミットメントの確立

最初の鍵は、取締役会や経営会議が「AIガバナンスは事業成長を支える戦略課題である」と宣言し、具体的なKPIと予算を割り当てることです。

AIプロジェクトの承認基準に「ガバナンス評価シートの提出」を義務づける、あるいは役員報酬にガバナンス指標を紐づけるなど、トップが旗を振る姿勢を可視化します。

これにより、現場はガバナンス活動を業務の一部として優先しやすくなります。

2.クロスファンクショナルなガバナンス委員会設置

経営層が方向性を示したあとは、データサイエンス、法務、セキュリティ、内部監査、現場部門を横断するガバナンス委員会を常設します。

委員会は方針策定とリスク評価のハブとなり、モデル開発の各ゲートで承認・差し戻しを判断します。議事録や承認フローを一元管理することで、外部監査への説明資料としても活用できます。

委員会は四半期ごとにKPI達成度をレビューし、経営層へ改善提案を報告します。

3.チェックリスト・監査ツール活用

委員会の決定を現場で確実に実装するには、具体的なチェックリストと自動監査ツールが必要です。

チェックリストは「データ取得元の正当性」「バイアス試験結果」「モデル説明資料の有無」など、工程ごとの必須項目を簡潔にまとめ、開発チームがセルフチェックできる形式にします。

あわせて、MLOps基盤にモデル監視ツールやセキュリティスキャナを組み込み、性能劣化や脆弱性をリアルタイムで検知できる仕組みを整えます。

これにより、ガバナンス活動が業務負荷ではなく、生産性向上の一部として機能し、PDCAのスピードも維持できます。

AIガバナンスを支援する主要ツールやサービス3種

AIガバナンスを机上のルールで終わらせないためには、プロセスを自動化し、エビデンスをリアルタイムで収集できるツール群を活用することが重要です。

ここでは「モデル監査」「データガバナンス」「プライバシー・セキュリティ」という3種類の代表的なソリューションをご紹介します。

1.AIモデル監査プラットフォーム

モデル監査プラットフォームは、学習データのバイアス検出、性能劣化のモニタリング、説明可能性レポートの自動生成をワンストップで行います。

これらの機能により、ガバナンス委員会が求める証跡を開発チームが即時に提示できるようになります。

具体的な評価軸としては以下が挙げられます。

- ハイリスク用途に対応したアルゴリズムテストの種類

- ダッシュボードでの可視化範囲

- MLOpsツールとのAPI連携可否

- 外部監査人向けエクスポート機能の有無

2.データガバナンス&ライフサイクル管理ツール

データガバナンスツールは、メタデータカタログ、アクセス権限管理、データ使用履歴のトレーサビリティといった機能で、AI開発の前提となるデータ品質を担保します。

導入メリットは、法規制で求められる「データ出所の説明」と「保存期間の明示」を効率よく実現できる点です。

選定時は以下のポイントに注目しましょう。

- 複数クラウドやオンプレ間での横串検索性能

- PII(個人識別情報)自動検出の精度

- データマスクや匿名加工のオプション

- AIモデル監査ツールとの連携テンプレート

3.プライバシー保護・セキュリティソリューション

プライバシー保護やセキュリティ対策を専門とするサービスは、差分プライバシーやホモモルフィック暗号を用いて個人情報を扱うAIにも安全性をもたらします。

さらに、敵対的サンプルの注入やモデルリバースエンジニアリングを検出する脆弱性スキャナを組み合わせることで、セキュリティインシデントの予防と早期発見が可能です。

導入時には以下を評価基準にすると良いでしょう。

- 暗号化手法による計算オーバーヘッド

- 既存キー管理システムとの統合性

- 攻撃シナリオ別のペネトレーションテスト支援

- 国内外の法規制(個人情報保護法、GDPRなど)に沿った設定ガイドの有無

これらのツールやサービスを組み合わせることで、チェックリスト運用の手間を削減しながら、AIガバナンスのPDCAを高速に回せる環境を整備できます。

AIガバナンスに関するよくある誤解4つ

最後に、AIガバナンスに関するよくある誤解を4つ紹介します。

誤解1.AIガバナンスを強化するとイノベーションが止まる

ガバナンスを取り違えて「制限」と同義に捉えるケースが散見されます。しかし、明確な評価基準と承認フローを設ければ、検証に必要なデータやモデルの品質条件が早い段階で共有されるため、手戻りが減り開発サイクルがむしろ短縮されます。

イノベーションを阻害するのは曖昧な判断基準であって、整備されたガバナンスではありません。

誤解2.法務部に任せれば十分

AIガバナンスは法的リスクだけでなく、技術的リスクや倫理的課題も含む横断領域です。データサイエンティストや情報セキュリティ担当、現場部門が連携しなければ、モデルの性能低下やバイアス検出といった技術上の課題を見逃す恐れがあります。

全社的なクロスファンクショナル体制を前提に考えることが重要です。

誤解3.ガイドラインを満たせばリスクはゼロにできる

ガイドラインは最低限の基準を提示するものであり、想定外の利用シナリオや環境変化まで完全にカバーできるわけではありません。AIシステムは運用を続けるうちにデータ分布が変化し、性能が劣化することがあります。

継続的なモニタリングと改善サイクルを回し続けてこそ、リスクを許容範囲に保てます。

誤解4.自社にハイリスク用途がないから対応は不要

検索補助や文書分類のように一見低リスクに思える用途でも、誤った出力が業務プロセスへ連鎖的な影響を与える可能性があります。また、取引先や規制当局がガバナンス体制の有無を取引条件とする動きも強まっています。

リスクレベルの高低にかかわらず、基本的なガバナンスフレームは整えておく必要があります。

AIガバナンスに関するよくあるご質問

AIガバナンスについて、お悩みの方に役立つQ&Aをまとめています。

AIガバナンスとは何ですか?

AIの企画〜運用〜廃止までを統制し、リスクを抑えつつ価値を最大化する枠組みです。

なぜ今必要になっているのですか?

生成AI普及と規制・社会的責任の強化で、事故がレピュテーションや業績に直結しやすいからです。取引要件になる場面もあります。

押さえるべき原則は何ですか?

透明性/説明責任、公平性、安全性、継続的改善などを社内ルールに落とし込みます。

体制づくりの第一歩は何ですか?

法務・セキュリティ・現場など横断で責任分界点と承認ゲートを作り、証跡管理と定期レビューを回します。

ツールは何を見ればよいですか?

モデル監査、データガバナンス、プライバシー/セキュリティの3系統で検討します。自動監視を運用に組み込むと回りやすいです。

まとめ

本記事では、AIガバナンスの基本概念から導入手順までを体系的に解説しました。

AIガバナンスとは、AIシステムの企画から運用・廃止に至るライフサイクル全体を経営レベルで統制し、リスクを抑えながら事業価値を最大化する枠組みです。生成AIの普及や各国の規制強化を背景に、ガバナンス体制の整備は企業競争力を左右する経営課題となっています。

AIにひそむリスクは技術面・倫理・法規制の三層に広がり、いずれも放置すれば誤判定や差別的判断、法令違反によってブランドと財務の両面に深刻な影響を与えかねません。これらを制御するうえで拠り所となるのが、透明性・公平性・安全性・継続的改善といった原則です。

方針を実務へ落とし込むには、Plan-Do-Check-Actの循環を組み込み、モデルやデータの変化を常時監視していく仕組みが不可欠です。

実装にあたっては、国際原則・地域法・国内指針・業界標準を重ね合わせ、自社に必要なチェック項目を整理すると抜け漏れを防げます。

経営層のコミットメント、部門横断型のガバナンス委員会、そしてチェックリストや監査ツールを活用した現場運用の三位一体で体制を固めると、AI活用のスピードを落とさずリスクを許容範囲に収めることが可能です。

さらに、モデル監査プラットフォームやデータガバナンスツール、プライバシー保護ソリューションを組み合わせれば、証跡収集や脆弱性検知を自動化でき、ガバナンスPDCAの回転速度を高められます。

AIの恩恵を最大化しつつ社会的信頼を獲得したい企業の皆さまは、まず経営トップの明確な方針表明から着手し、ここで示した実践ステップとツール選定のポイントをロードマップに落とし込んでみてはいかがでしょうか。

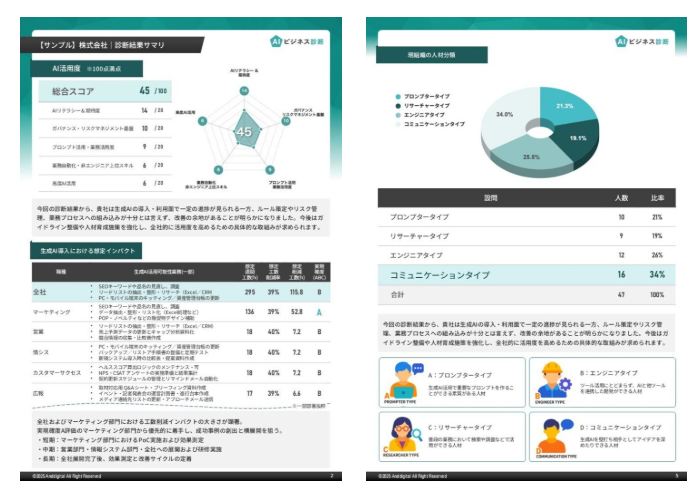

自社のAI活用ポテンシャルを客観的に可視化できる「AIビジネス診断」(PR)

AIビジネス診断とは、社内で生成AIを活用する事でどれくらいのビジネスインパクトがあるのか、ポテンシャルを把握できるサービスです。

生成AIを業務に取り入れたいものの「AIを活用したいが何から始めればいいかわからない」「本当に成果が出るのか?」といった悩みに対して、生成AIの実装フェーズに至るまでを一気通貫でサポートします。

■主なポイント

・アンケート・インタビューによる現状把握

・活用適性タイプの分類(例:プロンプター型、リサーチ型)

・専門家による診断レポートとコンサルティング

そのため、AI活用の「第一歩が踏み出せない」企業にとって、生成AIの活用ポイントや自社のポテンシャル把握、社内合意形成から実行支援までを担保する手段として非常に有効です。

詳細は下記URLから資料をダウンロードしてご確認ください。

「AIビジネス診断」のサービス概要資料をダウンロード(無料)