チューリングテストとは、コンピュータが人間と同じように会話できるかを評価する試験です。

このテストを指標にすることで、チャットボットや音声アシスタントが顧客との対話でどこまで「人間らしさ」を再現できるかを可視化でき、応対品質の向上やブランド信頼の強化といったビジネス効果が期待できます。

一方で、チューリングテストだけでは長期的な推論力や事実の正確性を測定できず、審査員の主観に左右されやすいなどの課題もあるため、導入時には補完的な評価指標や運用ガイドラインが欠かせません。

そこで本記事では、チューリングテストの基本と仕組み、メリット・デメリットを整理したうえで、BLEU/ROUGE・MMLU・MT-Benchなど最新ベンチマークとの比較、レッドチーミングやフィードバックループといった次世代の評価アプローチまでまとめて解説します。

AI評価の全体像を押さえたい方は、ぜひご一読ください。

- チューリングテストの定義と評価観点

- 導入メリットと実務での限界

- BLEUやMMLUなどとの使い分け

- レッドチーミング等の最新手法

- 実運用のフィードバック設計

【早見表】生成AIサービス主要20選(2025年版)【社内共有OK】

目次

チューリングテストとは

チューリングテストは「コンピュータが人間と区別できないほど自然に会話できるかどうか」を判定する試験であり、人工知能(AI)の“実用レベル”を測る最も古典的な指標の一つです。

1950年、数学者アラン・チューリングが論文『Computing Machinery and Intelligence』で提唱した「模倣ゲーム」を原型とし、テスター(審査員)がテキストチャット越しに人間とAIそれぞれと会話し、どちらがAIかを見抜けなければAIは合格と判断されます。

ポイントは、AIが内部でどのように推論しているかではなく、外部から観察できる“ふるまい”だけで評価するという点です。これにより、複雑なアルゴリズムや学習手法を知らなくても、ビジネスの現場で「このチャットボットは顧客に人間らしく応答できるのか」という問いをシンプルに検証できます。

チューリングテストが世に出た当時は、コンピュータが言語を処理すること自体が革新的でしたが、現在は大規模言語モデル(LLM)の登場によって“人間らしい文章”を出力するAIが急増しています。それでもなおチューリングテストが語られる理由は、「AIとの対話品質をビジネス価値へ直結させるメトリクス」としてわかりやすいからです。

顧客サポート、社内FAQ、パーソナルアシスタントなど、ユーザー体験が競争力につながる領域では「人間と区別できないほど自然か」という基準が説得力を持ちます。

同時に、この試験が“人間と同等の知能”そのものを証明するわけではなく、あくまで限定的な状況下における対話能力のテストである点も理解しておく必要があります。

参考:大規模言語モデル(LLM)とは?仕組みや活用方法を一挙解説!|LISKUL

- 内部構造ではなく外部ふるまいで評価

- 審査員がAIを見抜けない割合で判定

- 対話品質のビジネスメトリクスとして有効

- 知能の総合評価ではない点に留意

チューリングテストが注目される3つの理由

生成AIがビジネス現場へ浸透する現在、AIの対話品質をシンプルに可視化できる指標としてチューリングテストが再評価されています。

経営層にも分かりやすい数値が得られるだけでなく、規制対応やマーケティング効果にも直結するためです。ここでは注目度を押し上げている三つの理由を紹介します。

1.経営判断を後押しする直感的な評価軸として

BLEUなどの専門指標は非エンジニアにとって理解が難しい一方、「合格=人間と見分けがつかない」というチューリングテストの結果は非常に直感的です。

そのため、AI導入プロジェクトの投資対効果を経営層へ迅速に説明でき、商談チャットボットやカスタマーサポートのKPIとして採用しやすいという利点があります。

- 合格率という単純明快な指標

- 投資対効果の説明が容易

- KPI化して進捗管理に直結

2.規制と倫理リスクへの対処指標として

EUのAI Actをはじめとした各国の規制では、ユーザーがAIと気付かず利用する状況に懸念が示されています。チューリングテストを実施し、その合格率や失敗率を公開することで、対話AIがユーザーを誤認させるリスクを定量的に示すことができます。

結果は社内のコンプライアンス資料やリスク評価レポートの根拠データとして活用できます。

- 誤認誘発リスクの定量化

- 評価ログの監査証跡化

- 開示と透明性の確保

3.メディア・投資家が評価しやすい物差しとして

生成AI市場では「チューリングテストに合格したかどうか」がニュース性を帯びやすく、スタートアップは資金調達資料で合格実績を強調し、大手IT企業はPRイベントでデモンストレーションを行う傾向にあります。

このように、テスト結果がメディアの注目を集めやすく、投資家にも技術力を示しやすいことが、再び脚光を浴びる要因の一つとなっています。

- 技術優位性の分かりやすい証跡

- 外部評価との比較材料を提供

- 投資家コミュニケーションを強化

チューリングテストの仕組み

チューリングテストは、第三者(インタビュア)が「対話だけ」を手掛かりに、通信相手が人間かコンピュータかを判定するブラインド評価です。

評価対象となるのは内部のアルゴリズムではなく、外部から観察できる振る舞いだけであるため、難解な技術背景を共有しなくても実務で再現しやすい利点があります。

本章では、登場人物の役割分担、具体的な進行方法、そして合格ラインの考え方を整理し、ビジネスシーンでの応用イメージをつかんでいただきます。

インタビュア・被験者・コンピュータの役割

テストには3つの立場が存在します。インタビュアは評価者として両者へ同時に質問を投げかけ、回答内容から相手の正体を推測します。

被験者である人間は、コンピュータと同じインターフェース(通常はテキストチャット)を使い、できるだけ自然に返答します。

一方でコンピュータは、人間らしい語彙や文体を選択しつつ、誤りや矛盾が少ない回答を提示しなければなりません。

三者が物理的に隔離され、相互認識できない環境を保つことで、公平性と再現性が確保されます。こうした設定により、審査結果はシステム内部の複雑さよりも「対話体験の質」を反映するものとなり、顧客サポート用チャットボットなどビジネス領域での評価指標として説得力を持ちます。

- 同一インターフェースで回答

- 物理的隔離と情報遮断を徹底

- 語彙選択と一貫性が鍵

テスト実施フローと質問例

実施手順はシンプルです。まずインタビュアが同一の質問を人間とコンピュータ双方に送付し、一定時間内に得られた回答を比較します。

質問は雑談形式でも専門領域でも構いませんが、複数ジャンルを組み合わせることで回答の柔軟性を測りやすくなります。

たとえば「週末におすすめのレストランは?」といったライトなテーマで文脈理解を確認しつつ、「量子コンピュータの誤り訂正手法を説明してください」といった専門的な設問で知識の深度を探る進め方が一般的です。

オンライン環境では5〜10分程度のミニセッションを複数回行い、質問者を交代させることで統計的な偏りを減らします。こうした運用は、社内検証はもちろん、ユーザーテストイベントでのデモにも応用可能です。

- 複数ジャンルの質問で網羅

- 短時間セッションを反復

- 質問者交代で偏りを低減

合格ラインと議論のポイント

合否判定は、インタビュアが「コンピュータを見抜けなかった割合」がしきい値を下回るかどうかで決まります。

1950年代の原案では1/3以下が目安とされましたが、最近はテスト環境や質問内容が多様化しているため、企業ごとに目標値を設定するケースが増えています。

重要なのは、一度の成功で結論を出さず、審査員を変えて複数回試行し、回答ログを残して再評価できるようにすることです。

また、合格していても「人間並みの知能」を証明したわけではなく、特定状況下での対話性能を示すに過ぎない点を社内外に明示しておく必要があります。

このように合格ラインの数値とその解釈を丁寧に共有することで、投資判断やコンプライアンス対応においても誤解を生まず、テスト結果を有効活用できます。

- 目標値は用途別に設定

- 複数回試行で再現性を担保

- 知能の証明と混同しない

チューリングテストのメリット3つ

チューリングテストの長所は、技術者と非技術者が同じ尺度で対話AIの品質を議論できる点にあります。

試験結果は「人間と区別がつかないかどうか」という分かりやすい軸で示されるため、社内外の意思決定を迅速に後押しし、顧客体験の向上やブランド価値の訴求にも直結します。

本章では、再現のしやすさ、コミュニケーションコストの低減、そしてビジネス成果への結び付けやすさという3つの観点から利点を整理します。

1.シンプルで再現しやすい評価指標

チューリングテストは、チャットツールとタイマーさえあれば短時間で実施でき、予算や専用機材をほとんど必要としません。

アルゴリズムの詳細を開示せずに済むため、開発途中の試作品でも外部ベンダーに依頼せず社内チームだけで検証を重ねられます。

評価方法が単純であるほど試行回数を増やしやすく、統計的な有意差を確保したうえで改善サイクルを回せる点が大きな利点です。

- 低コストで短時間に実施可能

- アルゴリズム開示を不要化

- 反復評価で精度向上を促進

2.非エンジニアとの共通言語になる

経営層やマーケティング部門は、BLEUやF1 といった専門指標よりも直感的な指標を求める傾向があります。

チューリングテストの判定結果は「何%の審査員が見抜けなかった」というシンプルな数値で表現できるため、プロジェクトの進捗報告や導入効果の説明が格段にスムーズになります。

技術チームが複雑な概念をかみ砕いて説明する手間が減り、意思決定のスピードが上がることで競合より早くサービスを改善できます。

- 数値化が容易で共有しやすい

- 非技術者にも直感的に理解可能

- 意思決定スピードを底上げ

3.顧客体験とブランド価値を高めやすい

カスタマーサポートや営業チャットボットの領域では、「人間らしく応答できるか」が顧客満足度に直結します。

チューリングテストで高い合格率を示せば、ユーザーに対して自然な対話性能を約束でき、問い合わせ対応の負荷軽減と顧客ロイヤルティの向上を同時に実現しやすくなります。

さらに、合格実績を公表することで「先進的なAI活用企業」というブランドイメージにつながり、PR資料や投資家向けレポートでも説得力の高い訴求ポイントとなります。

- 自然な対話で満足度を向上

- 応対コストの削減に貢献

- 先進企業としての認知を獲得

チューリングテストのデメリットや課題3つ

チューリングテストは手軽に実施できる半面、測定できるのはあくまで特定状況下の対話能力に限られます。そのため「合格すれば知能が十分」と誤解されやすく、評価結果を間違った形で意思決定に結び付けるリスクがあります。

さらに、審査員の主観や実施コスト、法規制との整合性など複合的な課題が残っており、ビジネス利用には慎重な取り扱いが求められます。

1.評価範囲が限定的で誤解を招きやすい

チューリングテストが測定するのは文章表現の自然さや質問への即時応答力であり、長期的な推論能力やマルチモーダル理解を含む知的処理を保証するわけではありません。

それでも「合格=人間レベルの知能」と受け取られる場合があり、AIの安全性や汎用性を過大評価する原因になります。

特に業務システムへ組み込む際は、セキュリティ要件やドメイン知識への適合など別の品質評価を併用しなければ、導入後に期待外れとなる可能性があります。

- 長期推論や正確性は別評価が必要

- 合格=汎用知能と誤認しない

- 用途別KPIと併用して判断

2.審査員バイアスと再現性の確保が難しい

テスト結果は審査員の言語能力や質問スキル、文化的背景に左右されます。ユーモアや比喩を多用する審査員と、事実確認を重視する審査員では合格率が変動しやすく、単発の実験だけで客観性を担保するのは困難です。

また、審査員がAI技術に精通しているほど検出が厳しくなり、社外発表用と社内品質管理用で結果が食い違うケースもあります。

統計的に有意な回数を確保し、審査員構成を多様化するなど再現性を担保する工夫が欠かせません。

- 審査員の多様化と交代制

- 試行回数の確保と記録

- 評価プロトコルの標準化

3.実施コストと倫理・規制面での課題

テスト自体は簡素でも、合格率を高めるためにAIをチューニングし続けると開発・検証コストが膨らみます。さらに「人間を欺くこと」をゴールに設定する性質上、不透明な応答ロジックや誤情報の生成が増えるリスクもあります。

EUのAI ActなどではAIを使用している旨の明示が求められる場面があり、チューリングテストの目的と規制の方向性が衝突しかねません。

ビジネスで利用する場合は、結果をマーケティングに活用しつつも透明性を保つ運用ポリシーを策定し、規制要件との整合を取ることが重要です。

- AI利用明示と透明性の確保

- 誤情報対策と監視体制の整備

- 過度な最適化による偏りを警戒

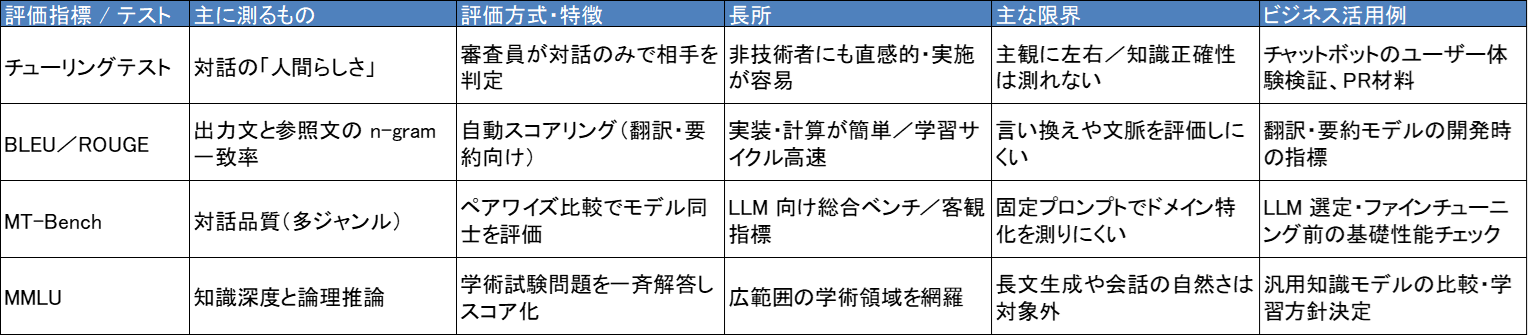

最新AI評価ベンチマークとの比較

チューリングテストだけでは把握しきれない「応答品質」「知識網羅性」「推論能力」を補うため、最新の自動ベンチマークが次々登場しています。

ここでは代表的な指標を取り上げ、評価対象・算出方法・活用領域を整理し、チューリングテストとどう使い分ければよいかを解説します。

BLEU・ROUGEなど従来の自動評価指標

BLEUやROUGEは、モデルが生成した文と参照文とのn-gram一致率をスコア化する仕組みです。機械翻訳や自動要約の分野で長く利用されており、学習サイクルを高速に回せる点が利点といえます。

一方で単語の表面一致に依存するため、語彙を変えた言い換え表現や文脈の妥当性までは十分に捉えられません。

その結果、人間が読むと自然に感じる出力でも低スコアになるケースがあり、対話システムの品質判断に単独で用いるのは適切とはいえません。

実務では、BLEU/ROUGEをモデル改良の目安にしつつ、ユーザーテストやチューリングテストで補正する運用が推奨されています。

- 学習サイクルの高速化に有効

- 表面一致依存の限界を理解

- 人手評価と併用して補正

MT-Bench・MMLUなどLLM専用ベンチマーク

大規模言語モデル(LLM)の能力を多角的に測るため、近年はタスク型のベンチマークが主流になっています。

たとえばMT-Benchは複数ジャンルの対話プロンプトを収録し、ペアワイズ比較でモデル同士の優劣を判定します。MMLUは中学レベルから大学院レベルまでの試験問題を集め、汎用的な知識と推論力を数値化するベンチマークです。

これらは客観的な共通課題でスコアを算出できるため、モデル選定や学習方針の指標として有用です。

しかし質問内容が固定されている分、実サービス固有の業務知識やドメイン表現を評価しにくい側面があります。そのため、自社サービスの導入判断では「LLM専用ベンチマークで基礎性能を確認 → チューリングテストでユーザー体験を検証」という2段構えが効果的です。

- 基礎性能の比較に最適

- ドメイン適合は別評価で補完

- 実地の対話検証と併用

チューリングテストの限界と補完策

チューリングテストは「人間らしさ」を評価する点でわかりやすい反面、正誤判定や論理的一貫性までは測定できません。また、審査員の主観が結果を左右するため、再現性の確保が課題になります。

こうした弱点を補完する策として、まずBLEU/ROUGEなどで言語的な表面品質をスクリーニングし、次にMMLUやMT-Benchで知識深度と推論力を確認し、最後にチューリングテストで対話体験を検証する三層評価が推奨されます。

さらに、実運用ではユーザー満足度アンケートや行動ログ分析を加えることで、モデル改善サイクルを定量・定性の両面から強化できます。

- 自動指標→能力指標→対話検証

- ログ分析とCSアンケを併用

- 定期再評価で劣化を検知

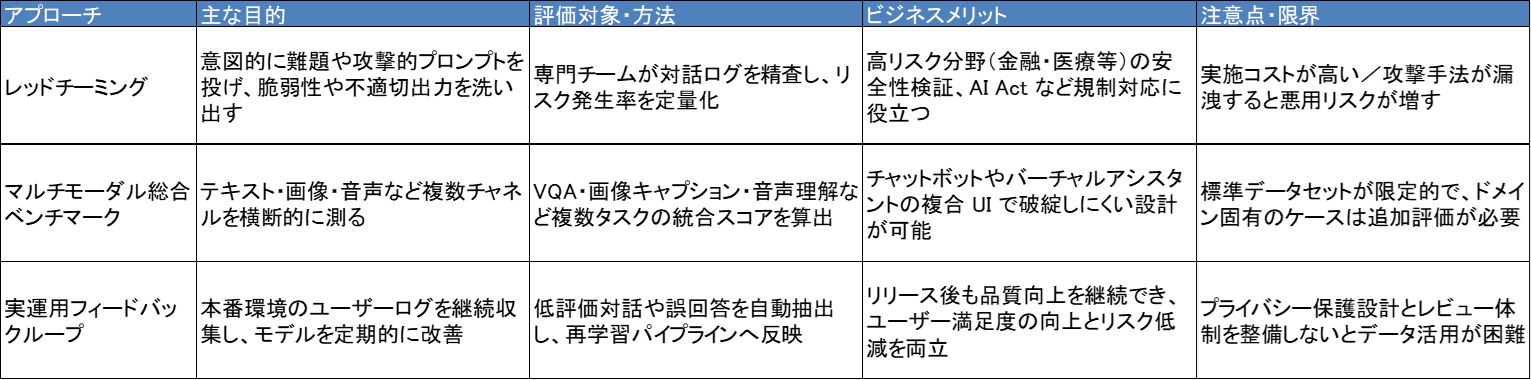

次世代の評価アプローチ

生成AIの実用化が進むにつれ、「人間らしさ」だけでなく安全性や信頼性を多角的に測る指標が求められています。

従来のチューリングテストや自動ベンチマークでは捉えきれないリスク(誤情報の生成、バイアスの増幅、悪用耐性の不足)を可視化するために、レッドチーミングやマルチモーダル評価、さらには実運用環境からのフィードバックループといった新しい手法が台頭しています。

ここでは、それぞれの特徴と導入メリットを解説し、企業がどのように組み合わせて品質管理を最適化できるかを紹介します。

レッドチーミングによる脆弱性探索

レッドチーミングは、専門家チームが意図的に難解な質問や攻撃的プロンプトを投入し、AIの弱点や不適切な出力を洗い出す評価手法です。従来のテストが「人間を欺けるか」を見るのに対し、レッドチーミングは「どこで破綻するか」をあぶり出します。

実施後には、リスクカテゴリごとに発生率を定量化し、モデルと監視システムの改善サイクルにつなげることが可能です。

EUのAI Actでも高リスク用途にレッドチーミングが推奨されており、金融や医療など誤情報の許容度が低い業界では必須プロセスになりつつあります。

- 破綻パターンと弱点を可視化

- リスク発生率を定量管理

- 是正措置と監視強化に直結

マルチモーダル総合ベンチマーク

テキストだけでなく画像・音声・動画を含むマルチモーダルAIが広がるなか、単一チャネルの指標ではユーザー体験を正確に測れません。

最新の評価フレームワークでは、視覚問答(VQA)や画像キャプション生成、音声理解など複数タスクを束ね、タスク横断スコアを算出する方法が採用されています。

これにより、チャットボットが製品画像を認識して説明する、コールセンターAIが音声感情を解析するなど、実サービスに近い条件で性能を比較できます。

導入企業は、複合タスクの弱点を早期に見つけ、多機能なUIでも破綻しにくい設計へと導くことができます。

- チャネル横断の一貫性を検証

- VQAや音声理解で実務近似

- UI統合時の破綻を事前把握

実運用データを活かすフィードバックループ

どれほど精巧なベンチマークでも、実際のユーザー行動には及びません。そのため、多くの企業は本番環境から対話ログや満足度アンケートを収集し、モデルの再学習やガイドライン修正に反映する「継続的フィードバックループ」を構築しています。

具体的には、誤回答が一定数を超えたテーマを自動抽出し、週次で修正パッチを適用する運用や、ユーザー評価★3以下の対話をヒューマンレビューに回して改善策を策定するフローが典型例です。

この循環を回すことで、静的ベンチマークでは発見できないドメイン固有の課題を解消し、サービス提供後も品質を向上させ続けることができます。

- 低評価ログの自動抽出と分析

- 週次パッチと再学習を定着

- ガイドライン改訂と周知徹底

チューリングテストに関するよくある誤解4つ

最後に、チューリングテストに関するよくある誤解を4つ紹介します。

誤解1.テストに合格すれば人間と同等の知能を備えている

チューリングテストが測定するのは、限定された条件下での対話の自然さだけです。長期的な推論力や創造性、マルチモーダル理解など総合的な知能を保証するものではありません。

合格していても、専門知識が欠けていたり、事実誤認を含む回答を返したりするケースは珍しくなく、ビジネス導入の際には追加の評価指標やガバナンス体制が不可欠です。

- 合格は対話品質の指標に過ぎない

- 知識精度と安全性を別途検証

- 用途別KPIで補完評価を実施

誤解2.一度のテスト結果で客観的な結論が得られる

試験の成否は審査員の質問内容や言語スキル、文化的背景に大きく左右されます。

単発のセッションで合格・不合格を決めても再現性は担保されず、異なる審査員や複数回の実施で統計的有意差を確かめる手順が欠かせません。

結果を経営判断やマーケティングに活用するなら、試行回数や審査員構成を公開し、検証プロセスの透明性を高めることが求められます。

- 多回試行と多様な審査員を採用

- 評価手順と条件を公開

- ログ保存で検証可能性を担保

誤解3.テキストで合格するAIは他のインターフェースでも優秀に振る舞う

テキストベースの対話に適したモデルでも、音声合成や画像認識を含むマルチモーダル環境では破綻する可能性があります。

音声ではイントネーションの不自然さ、画像では誤認識が顧客体験を損なう要因となるため、チャネルごとに専用の評価指標を組み合わせる必要があります。

テキスト合格をもって全チャネル対応だと判断するのは早計です。

- チャネル別に評価設計を分離

- 音声や画像指標を併用

- 実地テストで体験を検証

誤解4.不合格ならビジネス利用には向かない

合格ラインを下回っていても、FAQの自動回答や社内ナレッジ検索のように「人間と同等」を要件としない業務では十分な効果を発揮する場合があります。

重要なのはタスク要件に見合う性能かどうかであり、チューリングテストはあくまで指標の一つに過ぎません。不合格を理由に導入を断念するのではなく、用途やリスク許容度を踏まえて適切な運用設計を検討することが実務的です。

- 用途要件と必要性能を分離

- 段階導入で効果を検証

- 補助的な人手プロセスを併用

まとめ

本記事では、チューリングテストの概要から注目される背景、具体的な実施方法、メリット・デメリット、最新ベンチマークとの違い、次世代の評価アプローチまでを一挙に解説しました。

チューリングテストとは、インタビュアが対話だけを手掛かりに相手の正体を判定することで、AIの “人間らしさ” を測定する古典的な試験です。今日では、大規模言語モデルが業務に組み込まれる中で、非技術者でも理解しやすい指標として再評価されています。

仕組みはシンプルで再現も容易ですが、評価できるのは限定条件下の対話品質にとどまります。メリットとして、経営レイヤーを含む関係者間で共通言語になりやすく、顧客体験向上やブランド訴求に直結しやすい一方、主観に左右されやすい点や総合的な知能・安全性を保証しない点は課題です。

そこで本記事では、BLEU/ROUGE、MMLU、MT-Benchなどの自動ベンチマークを組み合わせた三層評価の考え方と、レッドチーミングやマルチモーダル総合ベンチマーク、実運用フィードバックループといった次世代アプローチを紹介しました。

これらを併用することで、対話品質・知識網羅性・リスク耐性を多角的に測り、モデル改善サイクルを加速できます。

AI導入を検討されている企業の皆さまは、チューリングテストを入り口に、目的に応じて複数の評価手法を設計し、透明性と安全性を両立させる運用ポリシーを整備することが重要です。

適切な指標とプロセスを選択し、ユーザー体験とガバナンスの両面からAI活用を最適化していきましょう。

生成AIサービス20選を一覧で比較(2025年版)

生成AIは日々のアップデートが急速で、ChatGPT、Claude、Gemini以外に業務特化の専門的な生成AIも増えてきました。

今回、今注目しておくべき生成AIツールを用途別に20個選出し、一覧表にまとめた資料をご用意しました。

サービス名・提供企業料金・AIごとの特徴・セキュリティ・利用されている分野など、一覧で比較できます。

- 導入検討の初期段階で候補を絞るとき

- 特定業務に適したツールを比較・整理するとき

- アップデートが追えていないので、一次整理を短縮したい

- 社内説明や稟議の補助資料として利用するとき

など、目的に応じてご活用ください。

特にChatGPT、Calude、Geminiについては種別(ROI改善や工数削減、リスク低減など)の導入効果事例をまとめており、利用シーンに応じた判断の補助として活用できるよう構成されています。

無料で取得できますので、ぜひお手元にダウンロードしてみてください。